「AIコーディングツールを使ってみたい。でも月額20ドルは高い。」

Claude Codeの名前を聞いて興味を持ったものの、Anthropic公式のProプラン(月額20ドル)に踏み切れない。そんな経験はないだろうか。

あるいはこう。「ローカルで動かせるらしいけど、RTX 4090とか持ってないし……」

前回のPart 2では、RTX 8000を2枚搭載した96GB VRAMの環境でOllamaのローカルモデルを検証した。結論としては「動くが、ハードウェアの壁が高すぎる」だった。72GBクラスのモデルを動かすには、一般的なPCでは到底足りないVRAMが必要になる。

しかし2025年後半、Ollamaに大きな変化があった。クラウドモデルの登場だ。

自分のPCにGPUがなくても、Ollamaのクラウドインフラでモデルが実行される。つまり、ノートPC1台あれば、480Bパラメータのコーディング特化モデルすら動かせる。しかも無料枠がある。

この記事では、GPUを持たない環境でOllamaのクラウドモデルを使い、Claude Codeを体験する方法を、実際のセットアップ手順から注意点まで詳しく解説する。

この記事が解決する悩み

- Claude Codeを試したいが、月額20ドルのサブスクに踏み切れない

- ローカルLLMに興味があるが、高性能GPUを持っていない

- ChatGPTとClaude Codeの違いがわからず、どちらに投資すべきか判断できない

自分がこの検証に至った背景

筆者はこれまで、ローカルLLM環境の構築を繰り返してきた。企業環境でのセキュリティ制約から「データを外部に出さずにAIを活用する」ことが命題だったからだ。

Part 2の検証では、RTX 8000を2枚(合計96GB VRAM)という環境でOllamaのローカルモデルを動かし、Claude Codeとの連携を試みた。結果は「技術的には動くが、ハードウェアコストが現実的でない」というものだった。

そこにOllamaのクラウドモデルが登場した。ローカルとクラウドのハイブリッドという、まさに求めていた選択肢だ。

ただし、筆者の本業は「データを外に出さない」ことを重視するローカルLLM志向だ。クラウドモデルは便利だが、データの取り扱いには注意が必要になる。この記事では、その両面を正直に伝える。

Ollamaクラウドモデルとは何か

Ollamaのクラウドモデルは、2025年9月にプレビューとして導入された機能だ。通常のOllamaはモデルをローカルPCにダウンロードして実行するが、クラウドモデルではOllamaのデータセンター側のGPUでモデルが実行される。

ユーザーから見ると、使い方はローカルモデルと全く同じ。ollama runやollama launchのコマンド体系も変わらない。違うのは、モデル名に:cloudというタグが付いている点だけだ。

ローカルモデルとクラウドモデルの比較

| 項目 | ローカルモデル | クラウドモデル | Anthropic公式API |

|---|---|---|---|

| GPU要件 | 高性能GPU必須(23GB VRAM以上推奨) | なし(ノートPCでOK) | なし |

| ストレージ | モデル分(数十GB) | ほぼ不要 | 不要 |

| コスト | 電気代のみ | 無料枠あり(Pro: $20/月) | Pro: $20/月 |

| 応答速度 | GPU性能に依存 | データセンター級GPU | 高速 |

| データ | 完全ローカル | Ollamaサーバーを経由 | Anthropicサーバーを経由 |

| 利用制限 | なし | 無料枠は軽量利用向け | プランに依存 |

| 使えるモデル | オープンソースモデル | オープンソースの大規模モデル | Claude(Sonnet/Opus) |

利用可能なクラウドモデル(主要なもの)

| モデル | パラメータ | 特徴 |

|---|---|---|

| qwen3-coder:480b-cloud | 480B | コーディング特化。最高性能 |

| deepseek-v3.1:671b-cloud | 671B | 汎用。高い推論能力 |

| gpt-oss:120b-cloud | 120B | 汎用性が高くバランス良好 |

| glm-4.7:cloud | 非公開 | バランス型。日本語にも対応 |

| minimax-m2.1:cloud | 非公開 | 軽量で高速 |

ポイントは、480Bや671Bといった超大規模モデルをGPUなしで動かせること。ローカルでこれらを動かすには、数百GBのVRAMが必要になるが、クラウドモデルなら一般的なノートPCで利用できる。

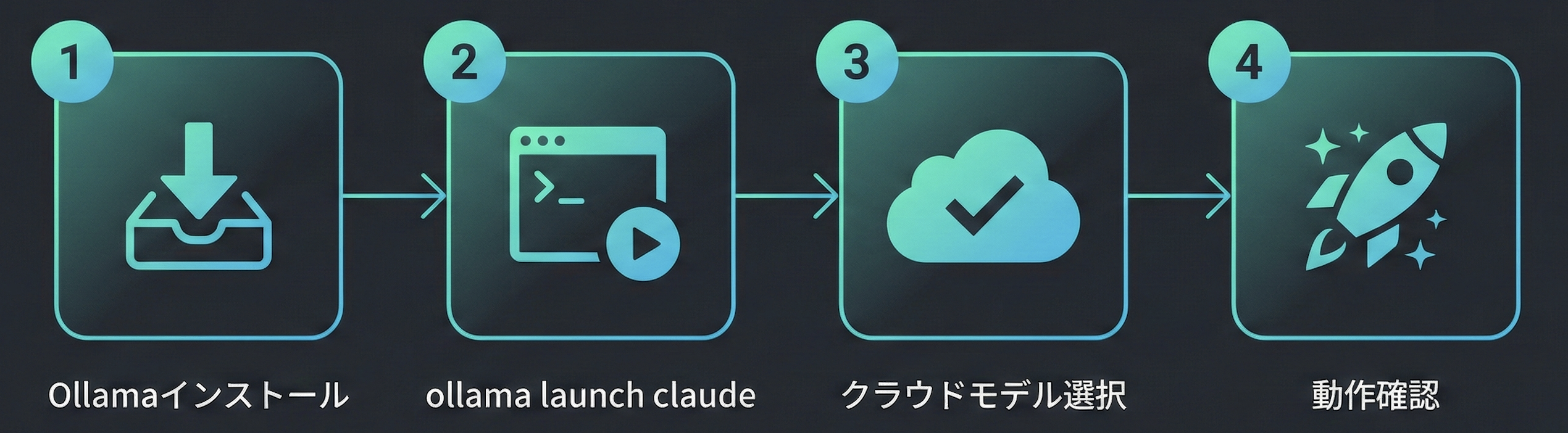

セットアップ手順:4ステップで完了

前提条件

- OS: macOS / Windows / Linux

- Ollama: v0.15以上(

ollama launchコマンド対応) - Node.js: v18以上(Claude Codeの実行に必要)

- Claude Code: 最新版(

npm install -g @anthropic-ai/claude-code)

Step 1: Ollamaのインストール・アップデート

Ollamaが未インストールの場合は、公式サイトからダウンロードしてインストールする。

既にインストール済みの場合は、v0.15以上であることを確認する。

ollama --version

# ollama version is 0.15.x 以上であることv0.15未満の場合は、公式サイトから最新版をダウンロードして上書きインストールする。

Step 2: ollama launch claude を実行

ターミナルで以下のコマンドを実行する。

ollama launch claudeこれだけで、対話的なセットアップウィザードが起動する。モデルの選択、環境変数の設定、Claude Codeの起動まで全て自動でガイドされる。

Step 3: クラウドモデルを選択

ウィザードが表示するモデル一覧から、クラウドモデル(:cloudタグ付き)を選択する。

コーディング用途であれば、qwen3-coder:480b-cloud が最もおすすめだ。480Bパラメータのコーディング特化モデルで、コード生成・修正・リファクタリングに高い性能を発揮する。

初回はOllamaアカウントへのサインインが求められる。Googleアカウントで認証できる。

# サインインが必要な場合

ollama signinStep 4: 動作確認

Claude Codeが起動したら、簡単なタスクを試してみよう。

> このディレクトリの構造を教えてファイル一覧が表示され、プロジェクト構造の説明が返ってくれば成功だ。

トラブルシューティング

起動しない場合の確認ポイント:

- Ollamaのバージョン:

ollama --versionでv0.15以上か確認 - Claude Codeのインストール:

claude --versionで確認 - ネットワーク: クラウドモデルはインターネット接続が必須

- 認証:

ollama signinでサインイン済みか確認

手動セットアップ(仕組みを理解したい人向け)

ollama launchは便利だが、裏側で何が起きているか理解しておくと、トラブル時に役立つ。

Claude Codeは本来、Anthropic APIと通信する。Ollamaはv0.14.0以降、Anthropic Messages APIと互換性のあるエンドポイントを提供している。つまり、Claude Codeの接続先をOllamaに向けるだけで連携できる仕組みだ。

手動で設定する場合、以下の3つの環境変数を設定する。

# 環境変数を設定

export ANTHROPIC_BASE_URL=http://localhost:11434

export ANTHROPIC_AUTH_TOKEN=ollama

export ANTHROPIC_API_KEY=""その後、使いたいクラウドモデルをpullして起動する。

# クラウドモデルをpull(初回のみ)

ollama pull qwen3-coder:480b-cloud

# Ollamaサーバーを起動(バックグラウンド)

ollama serve

# Claude Codeを起動

claude重要な設定として、Claude Codeは最低64,000トークンのコンテキストウィンドウを必要とする。Ollamaのデフォルトは4,096トークンなので、コンテキスト長を明示的に設定する必要がある。

# コンテキスト長を設定して実行

OLLAMA_CONTEXT_LENGTH=65536 ollama serveollama launchを使えば、これらの設定が全て自動で行われる。手動設定は「仕組みを理解したい」「既存の環境と統合したい」場合に有用だ。

ChatGPTとの違い:「指示待ち」vs「能動的」

Ollamaクラウドモデルを通じてClaude Codeを使うと、ChatGPTとの違いが体感できる。

| 比較項目 | ChatGPT | Claude Code(Ollama経由) |

|---|---|---|

| 起動方式 | ブラウザでチャット画面を開く | ターミナルでclaudeと入力 |

| データ認識 | チャットに貼り付けたテキストのみ | プロジェクト全体のファイル構造を自動認識 |

| 対話スタイル | ユーザーの指示に応答 | プロジェクトの文脈を読み、提案・修正を能動的に行う |

| ファイル操作 | コード生成は手動コピペ | 直接ファイルを読み書き・修正 |

| 適した作業 | 単発の質問、コードスニペット生成 | プロジェクト横断のリファクタリング、設計レビュー |

具体例:CSVが入ったフォルダを渡した場合

ChatGPTの場合:

- CSVファイルをアップロードする

- 「このデータを分析して」と指示する

- 分析結果がチャット上に表示される

- 追加の分析が必要なら、再度指示する

Claude Code(Ollama経由)の場合:

- CSVファイルがあるディレクトリでClaude Codeを起動する

- Claude Codeがディレクトリ内のファイルを自動認識する

- 「このデータの傾向を分析するスクリプトを作って」と言えば、Pythonスクリプトを生成し、実行し、結果をまとめてくれる

- 「グラフも出力して」と追加すれば、既存のスクリプトを修正してグラフ生成機能を追加する

この違いは「指示を出す → 結果を受け取る」のChatGPTに対し、Claude Codeは「文脈を理解して一緒にプロジェクトを進める」という体験だ。

ただし重要な注意点がある。Ollama経由で使うモデルはClaude(Anthropicのモデル)ではない。qwen3-coderやgpt-ossなどのオープンソースモデルだ。Claude Codeというツール(CLI)を使ってはいるが、中のモデルが異なる。そのため、Anthropic公式のClaude Sonnet/Opusと完全に同じ性能は期待できない。

知っておくべき注意点

1. 無料枠の制限

Ollamaの無料プラン(Free tier)は「軽量利用向け」と位置づけられている。具体的なトークン数やリクエスト数の上限は公開されていないが、長時間の連続コーディングセッションには制限がかかる可能性がある。

日常的に使い込むなら、Proプラン(月額20ドル)への移行が現実的だ。「それならAnthropicの公式に課金した方がよいのでは?」という判断も正しい。あくまでも「まず無料で体験し、AIコーディングツールの価値を見極める」ためのステップと捉えるのがよい。

2. データの取り扱い

クラウドモデルを使う場合、プロンプト(入力テキスト)はOllamaのサーバーに送信される。Ollamaは「データは保持しない」と表明しているが、ローカル実行と比べるとデータの外部送信が発生する点は理解しておく必要がある。

企業の機密コードや個人情報を含むプロジェクトでの利用は推奨しない。 個人の学習プロジェクトや公開リポジトリでの利用が適切だ。

3. Anthropic公式版との違い

繰り返しになるが、Ollama経由で動くのはオープンソースモデルだ。Claude Code(CLI)の機能(ファイル操作、Git連携、コマンド実行)は使えるが、モデルの性能はClaude Sonnet/Opusとは異なる。

具体的に異なる点:

- コード生成精度: 公式Claudeの方が高い傾向

- 日本語理解: モデルによってばらつきがある(glm-4.7は比較的良好)

- コンテキスト理解: 大規模プロジェクトでの文脈把握は公式Claudeが優位

4. コンテキストウィンドウの制約

Claude Codeは最低64,000トークンのコンテキストを要求する。クラウドモデルではこの要件を満たすが、以前のバージョンではクラウドモデルの出力が16,384トークンに制限されるバグが報告されていた(現在は修正済み)。常に最新版のOllamaを使うことを推奨する。

3段階のステップアップ戦略

この記事で紹介したクラウドモデルは、AIコーディングツールを「試す」ための入口だ。筆者が推奨するステップアップの流れを示す。

Step 1: 無料で体験(今回の記事)

- Ollamaクラウドモデル + Claude Code

- コスト: 0円

- 目的: AIコーディングツールの体験、自分のワークフローとの相性確認

Step 2: ローカルで本格運用(Part 2の内容)

- Ollama + ローカルモデル + 高性能GPU

- コスト: GPU購入費(中古RTX 3090で約5-8万円)

- 目的: データを外部に出さない完全プライベート環境

Step 3: 公式版で最高性能(Anthropic APIまたはProプラン)

- Claude Code + Claude Sonnet/Opus

- コスト: 月額20ドル

- 目的: 最高精度のAIコーディング、業務レベルの生産性向上

どのステップが最適かは、用途とデータの機密性に依存する。セキュリティ最優先なら Step 2、性能最優先なら Step 3、まずは試したいなら Step 1 だ。

まとめ:今すぐできる最小アクション

Ollamaのクラウドモデルにより、GPUなし・無料でAIコーディングを体験するハードルは劇的に下がった。

今すぐやるべきことは3つだけだ。

- Ollama v0.15以上をインストールする(ollama.com)

ollama launch claudeをターミナルで実行する- クラウドモデル(qwen3-coder:480b-cloud推奨)を選択して、自分のプロジェクトで試す

5分で環境は整う。

ただし、無料枠には制限がある。使い込んで「これは業務に使える」と確信したら、Anthropic公式のProプランへの移行を検討する価値がある。AIコーディングツールの真価は、継続的に使い込んで初めて実感できるものだ。

まずは無料で体験し、自分の目で価値を判断してほしい。

関連リンク

内部リンク(シリーズ記事)

外部リンク(公式ドキュメント・出典)

- Ollama公式サイト — ダウンロード・インストール

- Ollama Cloud Models — クラウドモデルの公式ブログ記事

- ollama launch 公式ブログ — launchコマンドの詳細

- Ollama × Claude Code 連携ドキュメント — 公式統合ガイド

- Ollama料金プラン — Free / Pro / Max の比較

- Claude Code公式 — Anthropic公式ドキュメント

コメント