こんにちは!

今回は話題の大型言語モデル(LLM)「Llama3」を、Dify と Ollama というツールを使って試してみました。最先端のAIがどんな反応を見せるのか、一緒に確かめていきましょう。

Llama3とは?

Llama3は、Meta社が開発した最新鋭のオープンソースLLMです。現在公開されているモデルの中でも最高クラスの性能を誇ると評価されています。Llama3の特徴は以下の通りです。

- 8Bと70Bパラメータの高性能な事前学習済みモデル

- 業界ベンチマークで実証された最先端の性能

- 推論性能改善などの新機能提供とマルチモーダル対応計画

- オープンソース化とコミュニティ主導の開発

- 責任あるAI開発をリードし、オープンなエコシステム発展に注力

Meta AIアシスタントの基盤としても活用され、より賢く速く楽しいAI体験の提供が期待されています。オープンかつ高性能なLLMとして、AIの民主化とイノベーション加速に貢献するでしょう

DifyとOllamaでLlama3を動かす

Llama3を手軽に使うために、今回は Dify と Ollama という2つのツールを試しました。

Ollamaのセットアップ方法

Ollamaのセットアップ方法については、以下の記事を参考にしてください

Difyのセットアップ方法

Difyの特徴やセットアップ方法については、以下の記事を参考にしてください

DifyでのOllama Llama3接続方法

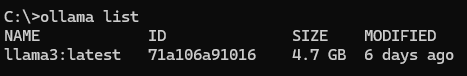

Ollama Llama3の起動確認

コマンドプロンプトでOllamaのLLMのリストにLlama3が存在することを確認します。

ollama list

llama3が表示されればOKです。

前提条件について

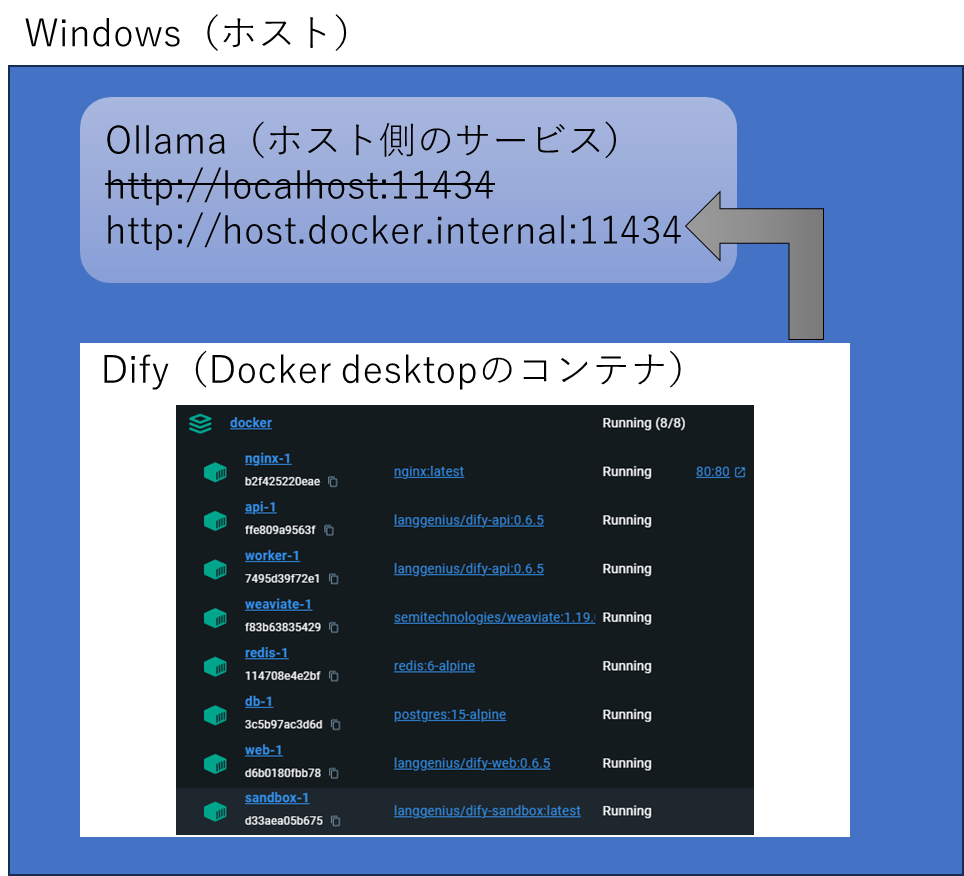

今回はDocker desktopで起動しているDify、Windowsプレビュー版のOllamaを使った組み合わせになっています。

この条件を明示的にした理由としては、Difyから見たときのOllamaのサービスのアドレスが変わってくるためです。

この条件を前提にした場合に、Dify側からホストに接続するときのIPアドレスはlocalhostではエラーになってしまいます。DockerのコンテナからホストのIPはアドレスを指定する場合には、「host.docker.internal」を使います。

設定

Difyの設定->モデルプロバイダーを開きます。

LLMの候補からOllamaを選び、「+ Add Model」をクリック

以下の画像のようにパラメータを入力します。

保存ボタンをクリックして、「成功」と表示されれば設定完了です。

Llama3を試してみた

実際にLlama3と会話してみました。

先に結果をお伝えすると、8Bの場合は話しかけている内容は理解してくれていますが、話す方の日本語は苦手なようです。

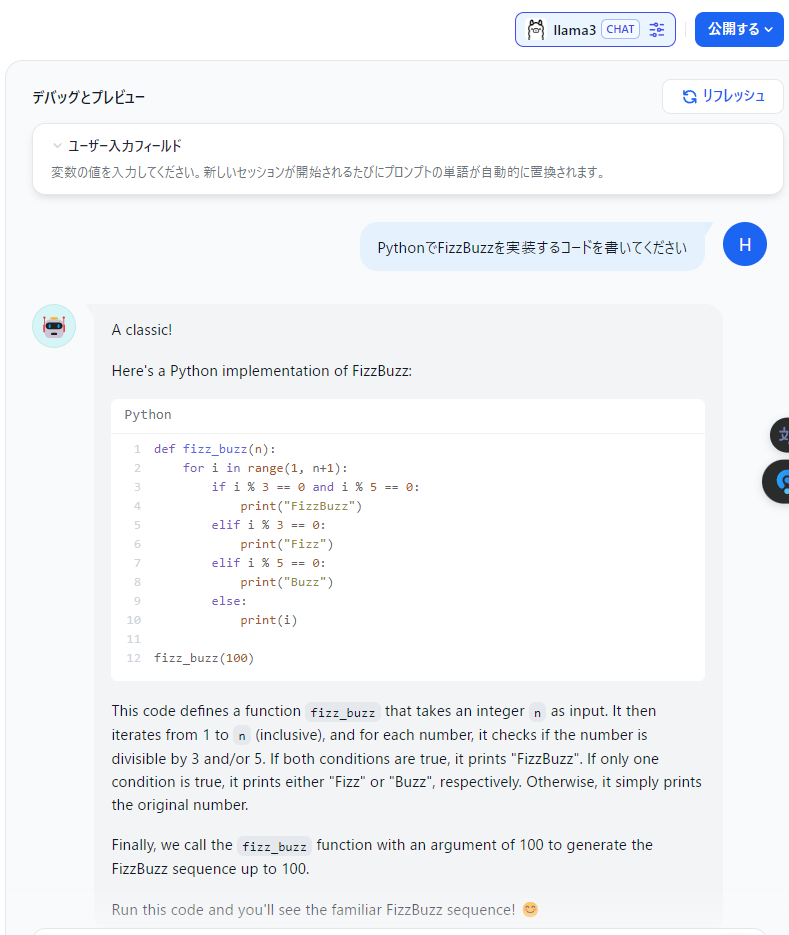

例:プログラミングの質問

私「PythonでFizzBuzzを実装するコードを書いてください」

まとめ

DifyとOllamaを使って最新LLM Llama3を試してみました。

今回はLlama3を試してみましたが、DifyとOllamaを組み合わせることでAPI利用料をかけることなく、ローカルLLMを簡単に利用できる環境を構築できます。

LLMの進化も早くどんどん新しいLLMが登場しています。それをすぐに試すことができ、利用料などもかからないのは魅力的ではないでしょうか。

今後はローカルLLMを色々試してみたいと思います。

コメント