はじめに

2025年7月30日、ローカルLLM界隈に激震が走りました。これまでコマンドライン(CLI)での操作が中心だったOllamaが、ついにGUI対応を果たしたのです。v0.10.0のリリースにより、ChatGPTのような直感的なチャットインターフェースでローカルLLMと対話できるようになりました。

「ローカルでAIを使いたいけど、黒い画面でコマンドを打つのは…😅」と躊躇していた方々に朗報です。これで誰でも手軽にローカルAIの世界へ足を踏み入れることができます。

Ollamaとは?これまでの課題

Ollamaは、Llama、Gemma、Mistralなど様々なオープンソースLLMを自分のPC上で簡単に実行できるプラットフォームです。完全にローカルで動作するため、プライバシーを重視する企業や個人開発者に愛用されてきました。

従来の課題:CLIの壁

これまでのOllamaの使用例:

– モデルをダウンロード

ollama pull llama3– モデルを実行

ollama run llama3– APIサーバーとして起動

ollama serveCLIに慣れた開発者には問題ありませんが、「黒い画面に文字を入力する」という操作は、GUI世代の多くのユーザーにとって心理的ハードルが高いものでした。

多くのユーザーは以下のような回避策を講じていました:

- Open WebUIを組み合わせてブラウザベースのUIを構築

- 独自のフロントエンドアプリケーションを開発

- LM Studioなどの他のGUIツールとの併用

しかし、これらの方法は追加の設定や知識が必要で、「気軽に試してみる」には敷居が高すぎました。

🚀 新生Ollama登場!主な特徴

1. ChatGPTライクなチャットインターフェース

- 見慣れた吹き出し形式の対話画面

- 過去の会話履歴を自動保持

- サイドバーからの簡単な履歴アクセス

- シンプルで迷わない操作感

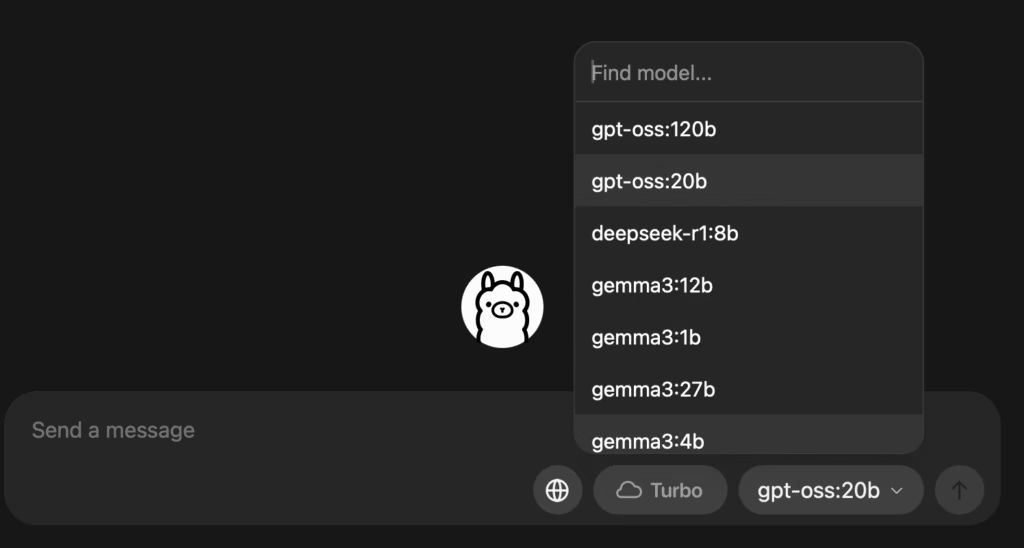

2. ワンクリックモデル管理

- GUI上でのワンクリックモデル選択

- 初回選択時の自動ダウンロード

- インストール済み/未インストールの明確な表示

- 用途に応じた簡単な使い分け

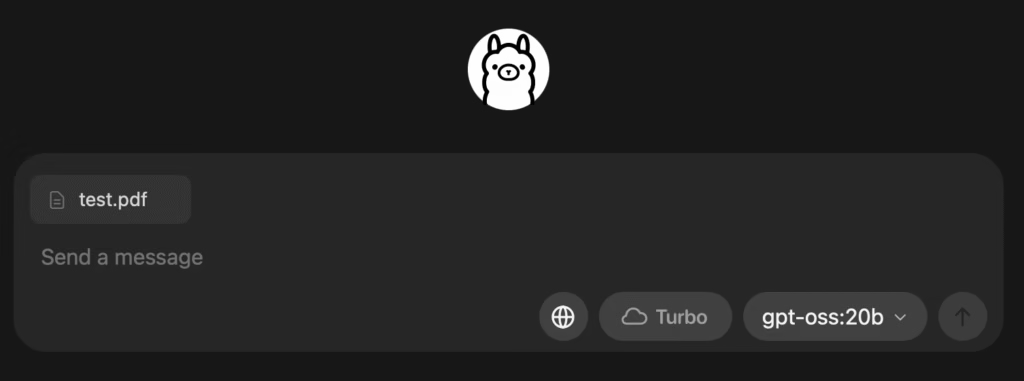

3. ドラッグ&ドロップファイル対応

対応ファイル形式:

- PDFファイル – 文書の内容について質問可能

- テキストファイル – コードレビューや文章分析

- 画像ファイル – マルチモーダルモデルでの画像認識

- Pythonスクリプト – コード解説や改善提案

4. マルチモーダル機能

対応モデル(Llama 3.2 Vision、Gemma 3など)なら:

- スクリーンショットや写真の解析

- 画像内容の説明や質問応答

- 視覚的な情報の文字化

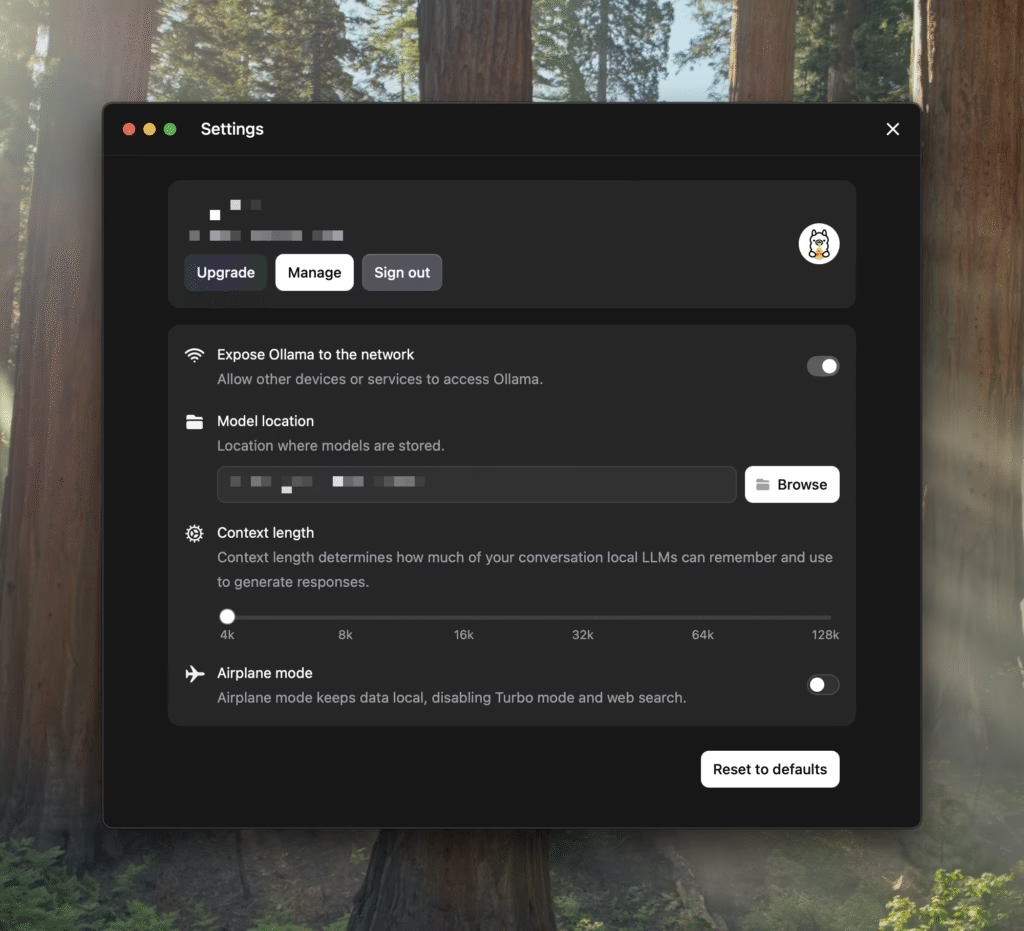

5. 柔軟な設定オプション

- コンテキスト長の調整

- モデル保存場所の変更

- ネットワーク公開設定

- デフォルト設定のカスタマイズ

📥 インストール手順

Step 1: ダウンロード

Ollama公式サイトからインストーラをダウンロード

Step 2: インストール実行

ダウンロードしたインストーラーを実行し、「Install」ボタンをクリック

Step 3: アプリ起動

スタートメニューからOllamaを起動。初回は自動でGUIが表示されます。

Step 4: モデル選択

チャットボックス右下のモデル選択でお好みのモデルを選択。初回は自動ダウンロードが開始されます。

💡 実際の使用感レポート

良い点

- 敷居の大幅な低下: これまでの「ちょっと試してみよう」→「コマンド思い出すの面倒」→「後でいいや」のサイクルが解消

- ファイル連携の便利さ: ドラッグ&ドロップでの文書解析が予想以上に実用的

- 直感的な操作: 普通のチャットアプリと同じ感覚で使用可能

改善余地のある点

- モデル検索機能: 前方一致検索に非対応、フルネームが必要

- PATH設定: ollamaコマンドが環境変数に自動追加されない

- 機能の制限: 現在はベーシックな機能のみ、今後のアップデートに期待

今後もバージョンアップで、どんどん改善されるでしょう。

🆚 従来のCLI vs 新GUI:使い分け指南

| 項目 | CLI | GUI |

|---|---|---|

| 起動速度 | 高速 | 標準 |

| 学習コスト | 高 | 低 |

| 自動化対応 | 優秀 | 限定的 |

| ファイル操作 | コマンド必要 | D&D対応 |

| 初心者フレンドリー | ✗ | ✅ |

| 開発統合 | ✅ | 今後対応 |

CLI推奨シーン

- スクリプトでの自動化

- 開発環境への統合

- バッチ処理

- サーバー環境での運用

GUI推奨シーン

- 初回体験・学習

- 文書分析・要約

- プロトタイピング

- 非技術者による利用

🌟 ローカルLLM普及への影響

今回のGUI対応は、ローカルLLM利用の「民主化」とも言える重要なマイルストーンです。

期待される変化

- 企業での導入促進: 技術者以外でも利用可能に

- 教育分野での活用: プログラミング教育での障壁低下

- 個人利用の拡大: AIリテラシー向上の入口として機能

- プライバシー重視層の取り込み: クラウドAIに抵抗がある層への訴求

まとめ

Ollama v0.10.0のGUI対応は、ローカルLLM界隈における非常に大きなインパクトを持つアップデートです。これまでCLIの壁に阻まれていた多くのユーザーが、ローカルAIの便利さを体験できるようになりました。

今すぐ試すべき理由:

- ✅ 完全無料でプライバシー保護

- ✅ インターネット不要のオフライン動作

- ✅ 企業データも安心して利用可能

- ✅ 継続的なコスト不要

ローカルLLMの新たな時代が始まりました。あなたも今すぐOllamaをダウンロードして、体験してみませんか?

参考リンク

コメント