はじめに

今回は、GitHubで公開されている革新的AIツール「MulmoChat」を実際にセットアップして動かしてみました。

音声だけで「画像生成」「Web要約」「スライド作成」までこなす、“AIネイティブOS”のような新体験です。

MulmoChatとは

MulmoChatは、音声入力をベースにAIと自然に対話しながら、

画像・スライド・解説動画などを生成できるマルチモーダルAIプラットフォームです。

開発者は中嶋聡氏(Windows95の父として知られるエンジニア)。

「テキストではなく“声”でAIを操作する」新しいUI/UXの可能性を探るプロジェクトです。

MulmoChatを詳しく解説した以前の記事はこちら

セットアップ方法

🔧 前提条件

Node.js と Yarn がインストールされていること。

Yarnのセットアップ方法の記事はこちら

🧩 インストール手順

git clone https://github.com/receptron/MulmoChat

cd MulmoChat

yarn install🔑 APIキー設定

.env ファイルを作成して以下を設定します:

今回の私が動作した際には、OpenAI,Gemini,Anthropicの3つのキーを設定しました。必須なのはリアルタイム音声会話のためのOpenAIと画像生成のGeminiの2つです。

OPENAI_API_KEY=sk-xxxx

GEMINI_API_KEY=xxxx

ANTHROPIC_API_KEY=xxxx▶️ 起動

yarn devブラウザで http://localhost:5173 を開くと、MulmoChatのUIが表示されます。

動作確認テスト(実際に試した結果)

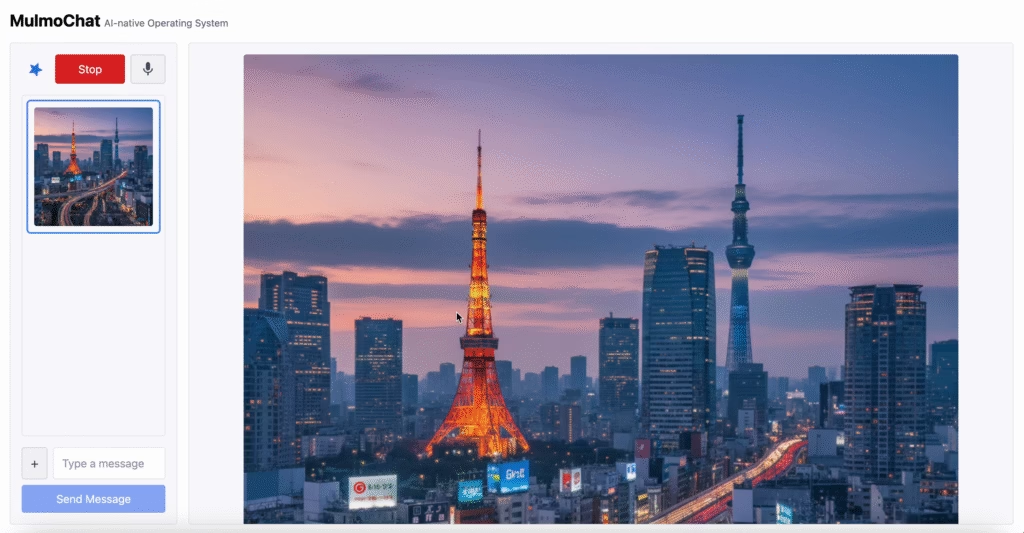

🎙️ テスト1:音声入力で質問

「日本の首都はどこ?」と話しかけると…

MulmoChatが「日本の首都は東京です」と解説しながら、

同時に東京の風景画像(東京タワー+スカイツリー)を自動生成しました。

📸 実際の出力画面:

音声指示だけでここまで自然に“答え+ビジュアル”が出るのは圧巻です。

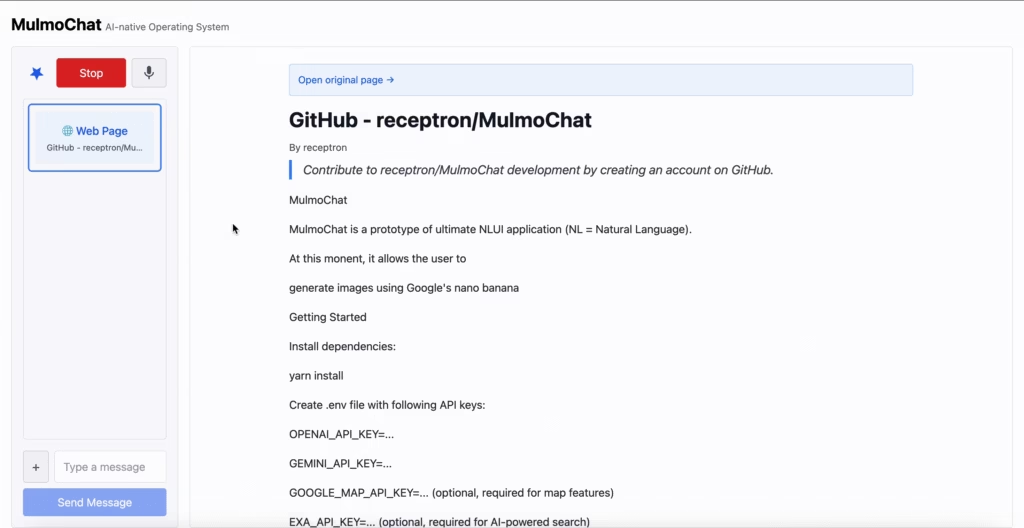

🌐 テスト2:リポジトリ読解機能

MulmoChatに自身のGitHubリポジトリURLを与えると、

内容を正確に解析し、READMEを要約表示してくれました。

📸 実際の画面:

APIキー設定や構造説明まで的確に抽出。

LLMによるWeb理解力の高さを実感しました。

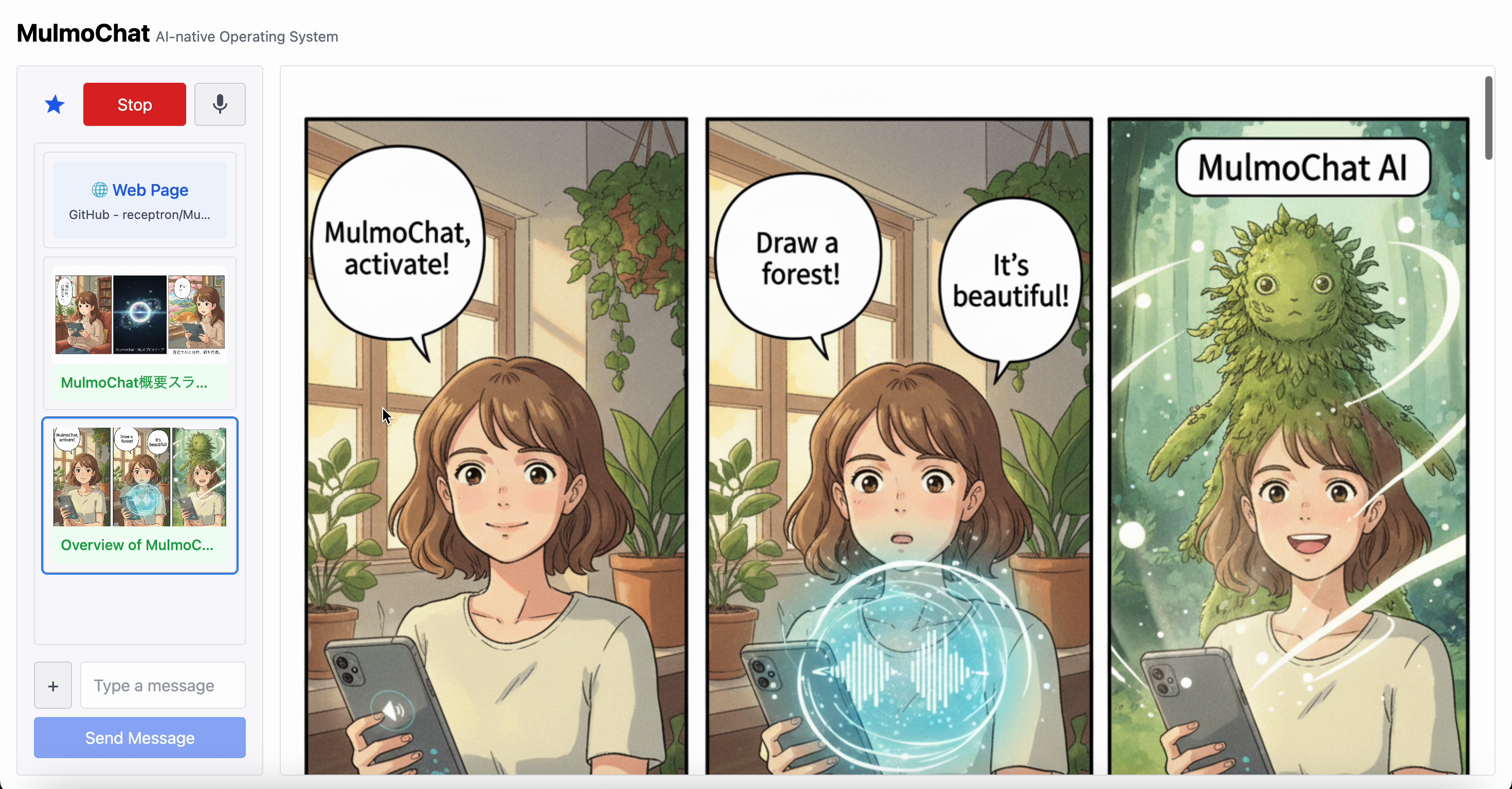

🖼️ テスト3:プレゼン資料の自動生成

次に、「MulmoChatについてプレゼン資料を作って」と話すと…

AIがスライドを自動構成し、漫画調・ビジュアルつきのスライドを生成。

日本語スライドでは一部文字化けが見られましたが、英語版は完璧な仕上がりでした。

📸 自動生成されたスライド:

特筆すべきは、スライド作成と同時に解説音声動画まで生成すること。

「AIが話しながら資料を説明する」未来のプレゼン形式を体験できました。

所感:まるで“声で動くAI OS”

MulmoChatは単なる音声チャットではなく、

「音声を軸にあらゆる情報生成を統合するインターフェース」と感じました。

特に印象的だった点:

- 🎤 音声認識と応答の自然さ(遅延ほぼなし)

- 🧠 画像+テキスト+スライドの連携がシームレス

- 🌍 GitHubなど外部情報の要約精度が高い

- 🎬 プレゼン資料+ナレーション動画という新たな出力形式

まとめ:体験してわかる“AIネイティブUI”

セットアップは簡単で、音声入力に慣れていない人でも直感的に使えます。

MulmoChatは「ChatGPTを超えて、“話すだけで作業が完結する”」未来の入口です。

🎯 一言で言うなら、AIとの対話で世界を描くツール。

生成AIによるさまざまな進化に加えてマルチモーダル技術を組み合わせた非常に面白いツールです。

まだまだ開発段階のツールで今後の進化も非常に楽しみです。この技術をオープンソースで公開してくれている中島さんに感謝です。

コメント